Se o processamento de big data tem te dado dor de cabeça, saca só: o Apache Spark é o que você precisa. Ele lida com volumes gigantescos de dados de um jeito que outras ferramentas engasgam. Neste post, vamos ver como ele pode acelerar seus projetos e te livrar de gargalos.

Desmistificando o Spark: Sua Arma Secreta no Mundo do Big Data

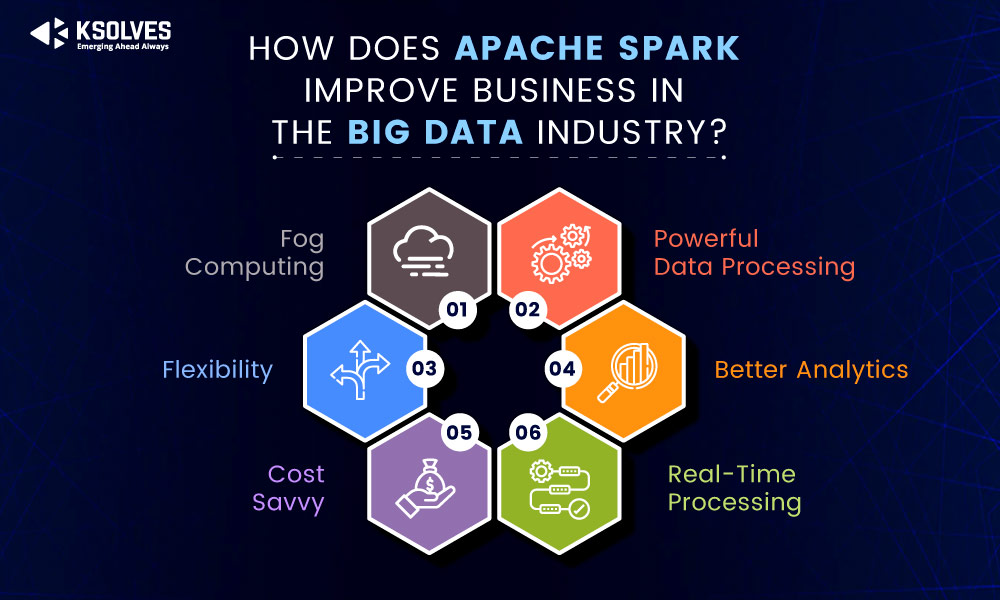

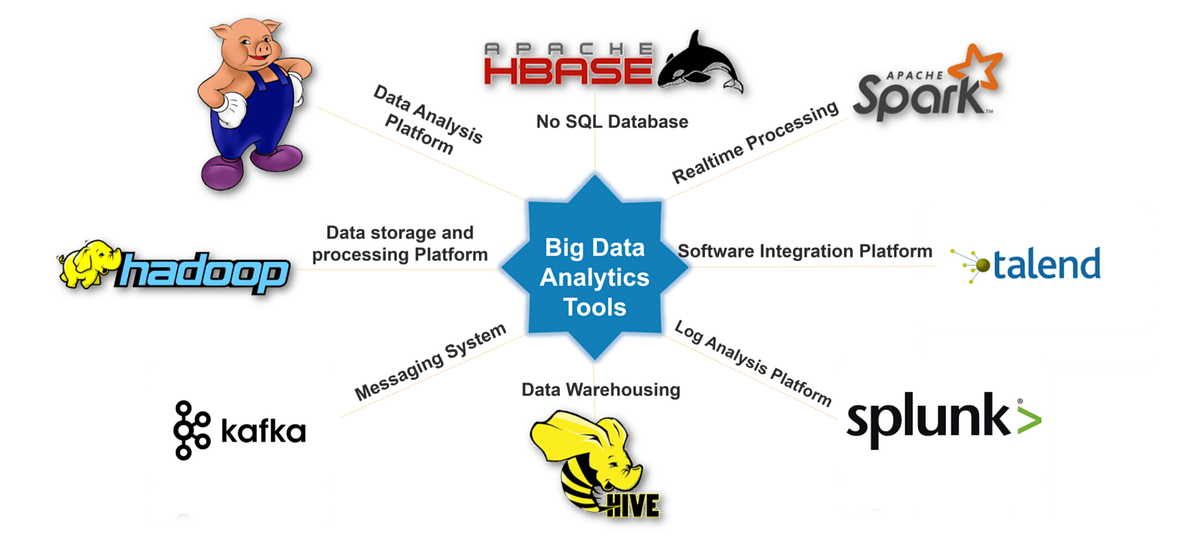

O Apache Spark é uma ferramenta fantástica para lidar com grandes volumes de dados. Pense nele como um motor superpotente que processa informações muito mais rápido do que as tecnologias antigas. Ele permite analisar dados de forma interativa e também em larga escala, o que é essencial hoje em dia.

A grande sacada do Spark é sua velocidade e versatilidade. Ele é conhecido por ser até 100 vezes mais rápido que o MapReduce para certas operações. Seja para machine learning, processamento em tempo real ou consultas complexas, o Spark entrega performance e flexibilidade. Ele se tornou a escolha padrão para muitas empresas que lidam com Big Data.

Confira este vídeo relacionado para mais detalhes:

Dominando o Spark: Um Guia Prático Para Suas Necessidades de Dados

O Que Realmente é o Apache Spark e Por Que Ele Mudou o Jogo?

Muita gente já ouviu falar em Big Data, certo? E quando o assunto é processar essa montanha de dados que a gente gera todo dia, o Apache Spark é o cara. Sabe, antes dele, lidar com volumes gigantescos de informação era um sufoco. O Spark mudou isso porque ele é incrivelmente rápido. Pense nele como um motor superpotente para analisar seus dados.

O grande diferencial do Spark é que ele trabalha com a memória RAM. Isso significa que ele carrega os dados na memória para fazer os cálculos, e não fica toda hora buscando no disco. Essa agilidade é o que faz toda a diferença em tarefas de larga escala. Ele não só processa dados em lote, como também lida com dados em tempo real e até mesmo com machine learning, tudo numa plataforma só.

Por que ele “mudou o jogo”? Simples: ele trouxe velocidade e eficiência para o mundo do Big Data. Antes, uma análise que levava horas, com o Spark podia levar minutos. Isso abriu portas para análises mais complexas e rápidas, ajudando empresas a tomarem decisões melhores. Vamos combinar, ter essa capacidade de análise rápida é um baita diferencial hoje em dia.

Dica Prática: Se você está começando com processamento de Big Data, comece explorando os exemplos de uso do Spark para entender na prática como ele lida com diferentes tipos de dados.

A Arquitetura do Spark: Entendendo os Componentes Essenciais (RDDs, DataFrames, Datasets)

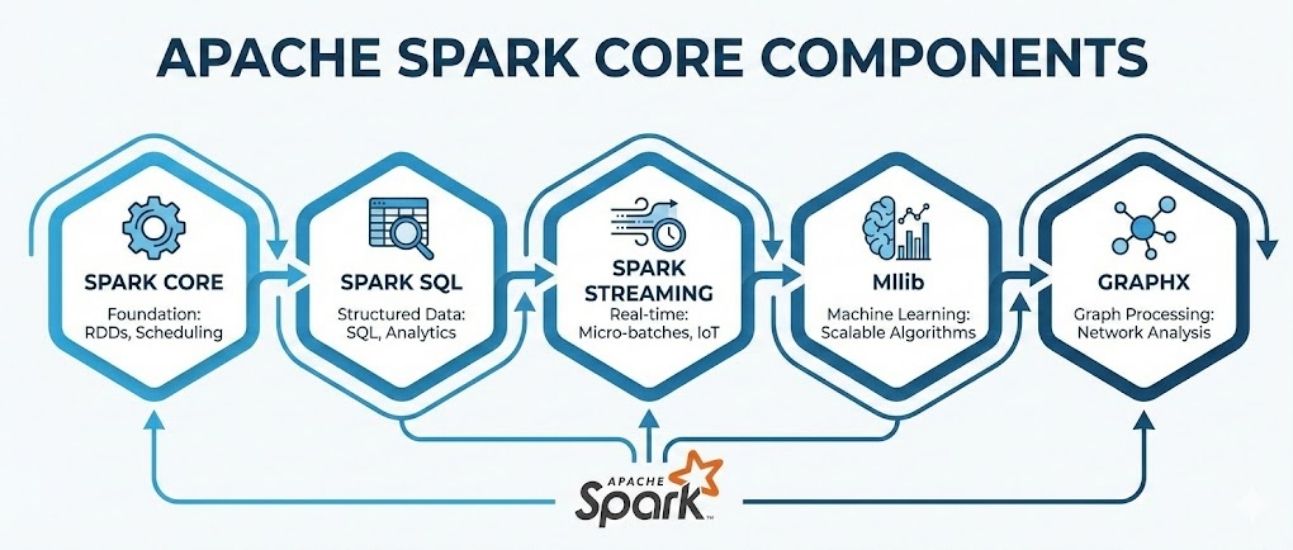

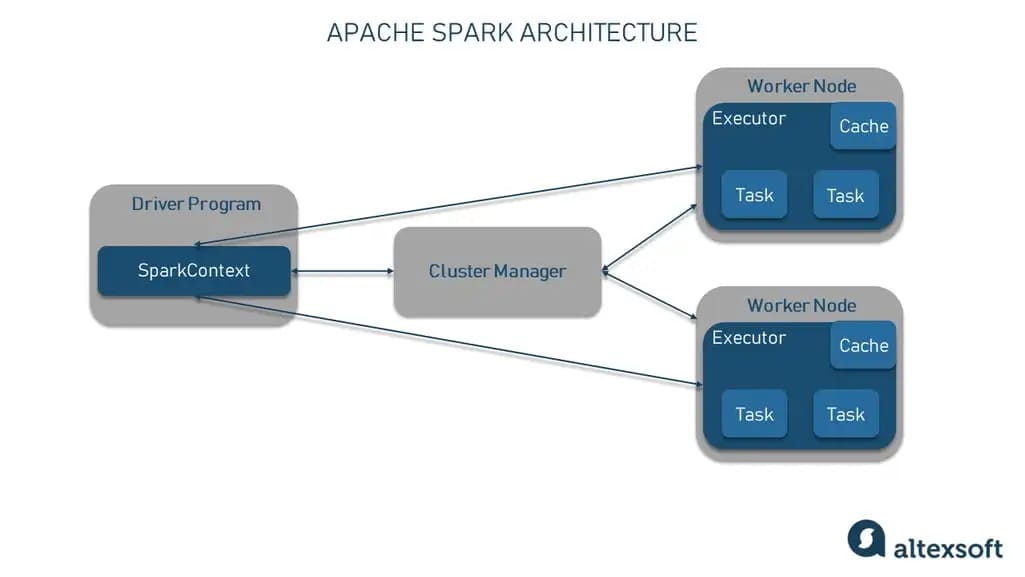

Quando falamos de spark para processamento de big data, a primeira coisa que vem à mente é a sua capacidade de lidar com volumes gigantescos de dados de forma rápida. Mas como ele faz isso? Tudo começa com a sua arquitetura, que é dividida em componentes chave. Pense neles como as engrenagens de um motor potente. Os mais importantes para você entender são os RDDs, DataFrames e Datasets.

Os RDDs (Resilient Distributed Datasets) foram a base inicial do Spark. São como listas de objetos distribuídas, imutáveis e tolerantes a falhas. Imagina que você tem uma lista enorme de informações espalhada por vários computadores. Os RDDs te dão uma forma segura de trabalhar com ela. Com o tempo, surgiram os DataFrames. Eles são uma abstração acima dos RDDs, organizando os dados em colunas com nomes, tipo um tabela de banco de dados. Isso facilita muito a consulta e manipulação. Os Datasets, por sua vez, combinam a orientação a objetos dos RDDs com a performance dos DataFrames, oferecendo tanto tipagem quanto otimização.

Para o seu dia a dia, entender a diferença ajuda a escolher a ferramenta certa. Se você precisa de muita flexibilidade e controle de baixo nível, RDDs podem ser úteis. Mas na maioria das vezes, especialmente em projetos de big data, os DataFrames e Datasets são mais eficientes e fáceis de usar. Eles permitem que o Spark otimize a execução das suas tarefas de forma automática.

Dica Prática: Para a maioria das tarefas de análise e processamento de big data com Spark, comece sempre explorando os DataFrames. Eles oferecem um ótimo equilíbrio entre performance e facilidade de uso, e você vai tirar muito mais proveito das otimizações automáticas do Spark.

Instalando o Spark: Um Roteiro Claro Para Começar Rápido

Muita gente acha que instalar o Spark para trabalhar com big data é um bicho de sete cabeças, mas eu te garanto que não é. O segredo é seguir um roteiro claro. Pense no Spark como seu novo braço direito para lidar com aquelas montanhas de dados que nenhuma planilha aguenta. Ele é rápido, flexível e, depois que você pega o jeito, abre um leque enorme de possibilidades. Vamos lá?

Para começar, você vai precisar baixar a versão mais recente do Spark. Acesse o site oficial e escolha a distribuição que melhor se adapta à sua necessidade. Geralmente, a versão pré-construída para Hadoop é uma boa pedida se você já mexe com esse ecossistema. Após o download, é só descompactar o arquivo em uma pasta de sua preferência. Simples assim. Para rodar o Spark, você pode usar o terminal. Imagine que você está entrando na pasta onde descompactou tudo e executando um comando como `./bin/spark-shell`. Pronto, você já está no ambiente interativo do Spark!

Se você precisa de mais flexibilidade ou quer integrar o Spark com outras ferramentas, considere a instalação via gerenciador de pacotes. Em distribuições Linux como Ubuntu, por exemplo, um simples `sudo apt install spark` pode resolver a maior parte do trabalho. Para quem usa macOS, o Homebrew facilita bastante. O importante é que, uma vez instalado, você já pode começar a explorar as capacidades do Spark para seu processamento de big data.

Dica Prática: Antes de instalar, verifique os pré-requisitos do sistema. Geralmente, o Spark precisa de Java instalado. Uma versão recente do Java faz toda a diferença na performance.

Seu Primeiro Processamento com Spark: Exemplo Prático e Detalhado

Seu primeiro contato com o Spark pode parecer um bicho de sete cabeças, mas eu te garanto que é mais tranquilo do que parece. O Spark é uma ferramenta sensacional para lidar com grandes volumes de dados (o famoso “big data”). Pensa comigo: você tem aquela montanha de informações e precisa extrair algo útil dela. O Spark entra em cena para fazer esse trabalho de forma rápida e eficiente. Vamos ver um exemplo simples para você pegar o jeito.

Para começar, você vai precisar ter o Spark instalado. Se você já usa Python, vai achar a sintaxe bem familiar. Imagine que temos um arquivo CSV com alguns dados de vendas. Com o Spark, você pode carregar esse arquivo em um DataFrame, que é como uma tabela inteligente. A partir daí, você pode fazer consultas, filtrar informações, agrupar dados e muito mais. Por exemplo, para contar quantas vendas ocorreram em cada cidade, o código é direto e você vê o resultado em segundos, mesmo com milhões de registros.

O bacana é que o Spark distribui o processamento entre vários núcleos do seu computador ou até mesmo em um cluster de máquinas. Isso acelera tudo absurdamente. Você não precisa se preocupar com a complexidade da paralelização, o Spark cuida disso para você. É a ferramenta ideal para quem quer explorar o potencial do spark para processamento de big data sem se perder em detalhes técnicos excessivos.

Dica Prática: Comece com conjuntos de dados pequenos para se familiarizar com os comandos do Spark. Depois, vá aumentando a complexidade gradualmente.

Spark SQL: A Maneira Inteligente de Consultar Seus Dados em Larga Escala

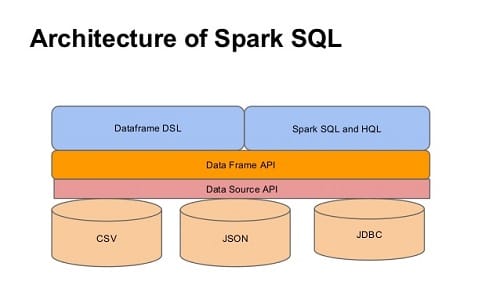

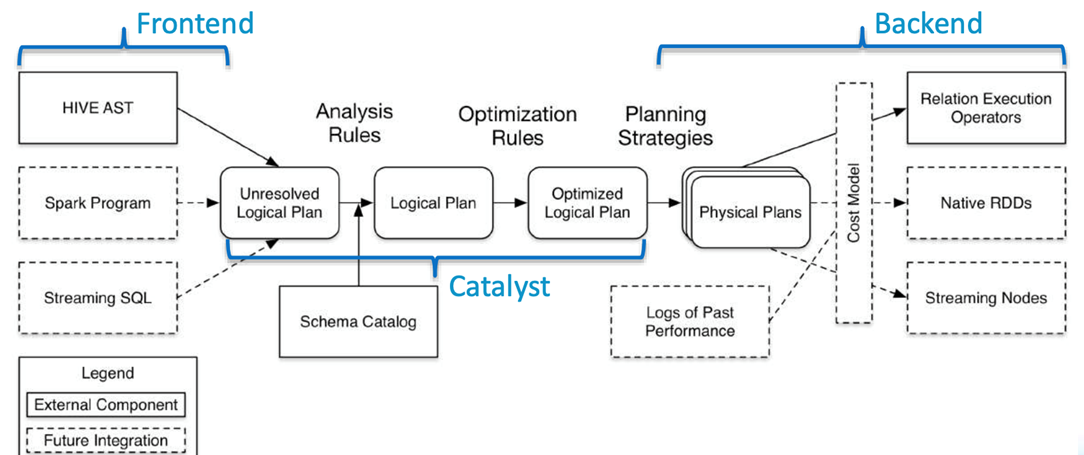

Se você trabalha com big data, já deve ter sentido a dor de tentar organizar e extrair informações de montanhas de dados. O Spark SQL surge como uma solução inteligente para isso. Ele permite que você execute consultas em seus dados usando SQL, a mesma linguagem que você usaria em um banco de dados tradicional. A grande sacada aqui é que o Spark foi feito para ser rápido, muito rápido, mesmo com terabytes de informação. Ele não só acelera suas consultas, como também simplifica o acesso aos dados, sem que você precise se aprofundar em APIs complexas de processamento distribuído logo de cara.

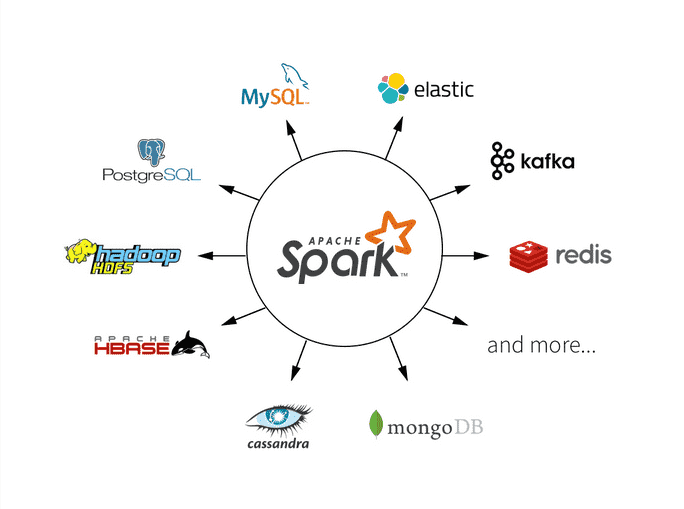

O Spark SQL funciona com diferentes fontes de dados, como arquivos Parquet, JSON, CSV e até mesmo tabelas em bancos de dados relacionais. Você pode carregar esses dados em “DataFrames”, que são estruturas de dados organizadas em colunas, bem parecidas com tabelas. A partir daí, é só usar a sintaxe SQL para filtrar, agrupar, juntar e analisar tudo. Essa facilidade de uso é um dos grandes diferenciais para quem está começando ou quer agilizar tarefas de análise de dados.

Essa capacidade de integrar o poder do Spark com a familiaridade do SQL é o que o torna tão popular para processamento de big data. Você pode construir pipelines de dados complexos de forma mais intuitiva e eficiente. É uma ferramenta que realmente ajuda a extrair valor dos seus dados em larga escala, tornando a análise algo mais acessível e produtivo.

Dica Prática: Ao trabalhar com DataFrames no Spark SQL, prefira carregar seus dados no formato Parquet. Ele é otimizado para performance e compressão, o que pode fazer uma diferença enorme na velocidade das suas consultas em big data.

Machine Learning com MLlib: Capacitando Suas Análises Preditivas

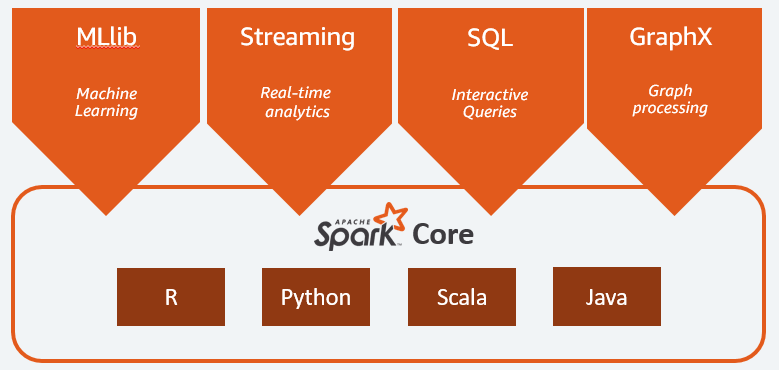

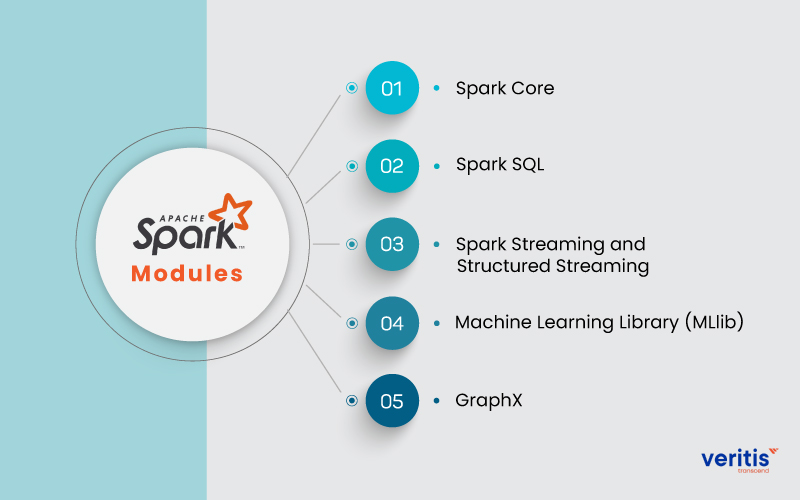

Sabe quando você tem uma montanha de dados e precisa tirar algo valioso dela para prever o futuro? É aí que entra o Machine Learning com o MLlib. Pense nele como um super ajudante dentro do Apache Spark, feito para quem mexe com spark para processamento de big data. Ele traz um monte de ferramentas prontas para você construir modelos que aprendem com seus dados.

Com o MLlib, você não precisa começar do zero. Ele oferece algoritmos de classificação, regressão, clustering e recomendação. Quer prever quais clientes vão comprar um produto novo? Ou detectar anomalias em transações financeiras? O MLlib tem as funções que você precisa para isso. E o melhor: ele é otimizado para rodar em clusters, ou seja, processa tudo rapidinho, mesmo com volumes gigantes de informação.

O MLlib simplifica demais o desenvolvimento de modelos preditivos. Você pode focar na análise e na interpretação dos resultados, sem se perder em detalhes de implementação de algoritmos complexos. Ele se integra perfeitamente com outras partes do Spark, como o Spark SQL e o Spark Streaming, permitindo fluxos de trabalho completos.

Dica Prática: Comece explorando os exemplos de código que o próprio Apache Spark disponibiliza. Eles são ótimos para entender como aplicar os algoritmos do MLlib na prática com seus dados.

Processamento de Streaming com Spark: Dados em Tempo Real na Palma da Mão

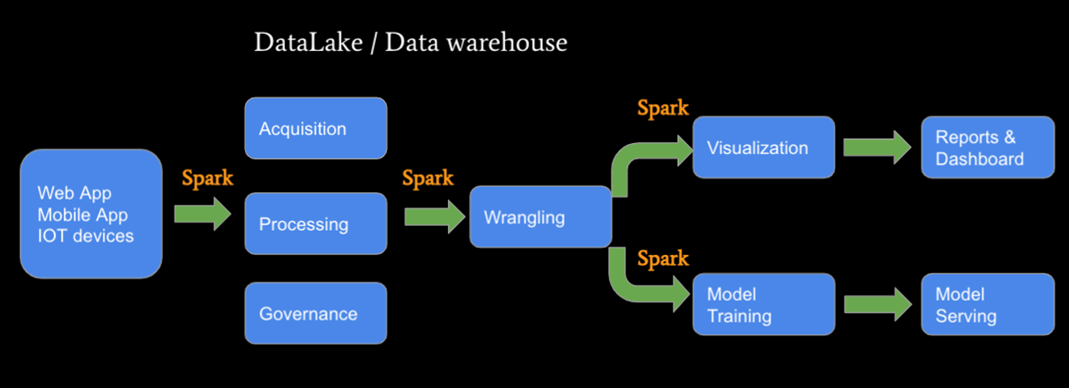

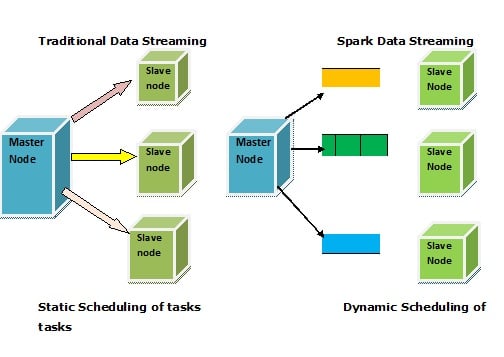

Você já parou para pensar em como aplicativos como os de entrega ou de transporte conseguem mostrar o movimento dos seus pedidos ou motoristas em tempo real? A resposta muitas vezes está no processamento de streaming. E quando falamos de big data, o Apache Spark se torna um campeão nessa área. Ele é capaz de lidar com fluxos contínuos de dados, analisando cada pedacinho assim que ele chega. Pense nisso como uma linha de produção super rápida, onde cada peça é inspecionada no momento exato.

O Spark para processamento de big data funciona com um conceito chamado Spark Streaming, que estende o processamento em lote para dados em tempo real. Ele pega o fluxo de dados e o divide em pequenos lotes (micro-batches). Essa abordagem permite que você aplique as mesmas operações poderosas do Spark que usaria para dados estáticos, mas agora em dados que estão sempre mudando. Isso abre um leque enorme de possibilidades para análises que precisam de agilidade.

A beleza disso é que você não precisa esperar horas para ter uma visão atualizada. Com o Spark, você pode reagir a eventos quase que instantaneamente. Isso é crucial para detectar fraudes, monitorar redes sociais, analisar dados de sensores em IoT (Internet das Coisas) e muito mais. A capacidade de processar e agir sobre dados em tempo real é o que impulsiona muitas das tecnologias que usamos todos os dias.

Dica Prática: Ao configurar seu ambiente Spark para streaming, lembre-se de ajustar o tamanho dos seus micro-batches. Lotes menores significam latência menor (dados mais próximos do tempo real), mas podem consumir mais recursos computacionais. Encontre o equilíbrio certo para sua aplicação.

Otimizando o Desempenho do Spark: Dicas de Um Experiente Para Você

Olha, você quer fazer o Spark rodar no seu máximo para processar aqueles montanhas de dados, né? Eu já passei um bocado de tempo mexendo com isso, e fico feliz em dividir umas sacadas que fazem a diferença. Quando a gente tá falando de Big Data, cada milissegundo conta. E o Spark, esse motorzão, tem umas particularidades que, se você souber explorar, ele voa baixo.

Uma coisa que eu aprendi na marra é sobre a memória. O Spark adora memória RAM. Se o seu cluster tá sofrendo com falta de memória, o desempenho despenca. Ajustar o `spark.executor.memory` e o `spark.driver.memory` é fundamental. E não se esqueça de observar o GC (Garbage Collection). Um GC muito ativo é sinal de que a memória está apertada. Para o spark para processamento de big data, gerenciar isso é ouro puro.

Outro ponto crucial é o particionamento dos dados. Dados mal particionados geram o que chamamos de “skew”, que é quando uma partição fica sobrecarregada enquanto outras ficam vazias. Isso mata a performance. Reparticionar seus RDDs ou DataFrames de forma inteligente pode equilibrar a carga de trabalho. Pense nisso como organizar um time para que todos joguem com a mesma intensidade.

Dica Prática: Use o `repartition()` ou `coalesce()` com cuidado, e sempre monitore o tamanho das suas partições durante a execução do job. Dê uma olhada nas métricas do Spark UI para identificar partições desbalanceadas.

Spark vs. MapReduce: Por Que o Spark Ganhou Tanta Popularidade?

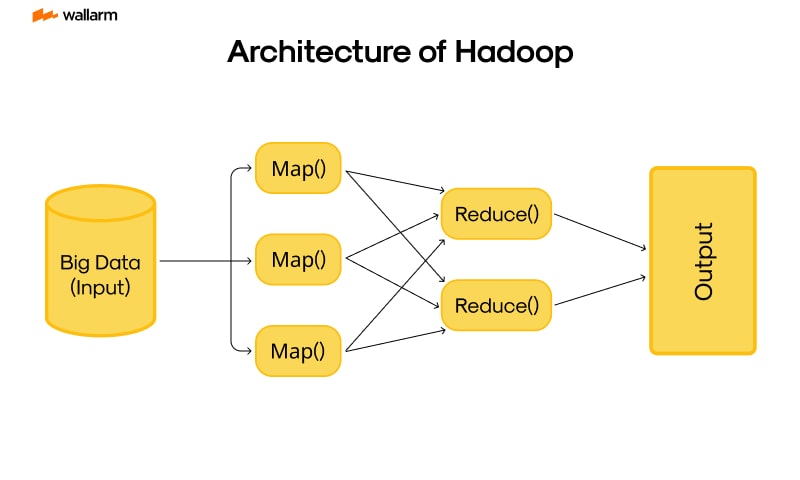

Vamos falar de Big Data. Por muito tempo, o MapReduce foi o queridinho para processar essa montanha de dados. Ele funciona em etapas, lendo do disco, processando e escrevendo de volta. É um método confiável, mas, convenhamos, às vezes ele demorava um bocado para entregar o resultado. Aí apareceu o Spark, e a gente logo percebeu a diferença.

A grande sacada do Spark está na memória. Em vez de ficar lendo e escrevendo tudo no disco, ele mantém os dados na memória RAM. Isso faz com que as operações fiquem drasticamente mais rápidas. Pense em processar terabytes de dados em minutos, algo que antes levava horas. O Spark para processamento de Big Data realmente mudou o jogo nesse quesito.

Essa velocidade de processamento em memória é o que fez o Spark decolar. Ele não só é mais rápido, como também oferece mais flexibilidade. Dá para fazer análises interativas, machine learning e processamento em tempo real com muito mais eficiência. O MapReduce fez um trabalho importante, mas o Spark entregou o desempenho que o mercado precisava.

Dica Prática: Se você está começando com Big Data e quer resultados rápidos, priorize o aprendizado do Spark. Sua curva de aprendizado é acessível e o retorno em performance compensa muito.

Casos de Uso Reais: Onde o Spark Brilha no Mercado Brasileiro

Quando o assunto é processamento de big data no Brasil, o Spark não brinca em serviço. Ele é usado para analisar quantidades enormes de dados que simplesmente não caberiam em um computador comum. Pense em bancos que analisam milhões de transações por segundo para detectar fraudes, ou em empresas de telecomunicações que processam dados de uso para entender melhor seus clientes.

A velocidade do Spark é um dos seus grandes trunfos. Ele consegue rodar até 100 vezes mais rápido que o Hadoop em memória, o que é crucial quando você precisa de respostas rápidas. Isso significa que empresas conseguem tomar decisões em tempo real, como ajustar preços de produtos online ou otimizar rotas de entrega com base em dados atualizados.

No varejo, por exemplo, o Spark é essencial para personalizar a experiência do cliente. Ele analisa o histórico de compras, o comportamento de navegação e até interações em redes sociais para oferecer promoções e recomendações sob medida. É assim que algumas lojas sabem exatamente o que você quer antes mesmo de você pedir. Fica tranquila que essa tecnologia está democratizando o acesso a análises complexas. Se você está começando com big data, foque em entender os fundamentos do processamento distribuído antes de pular para ferramentas mais avançadas.

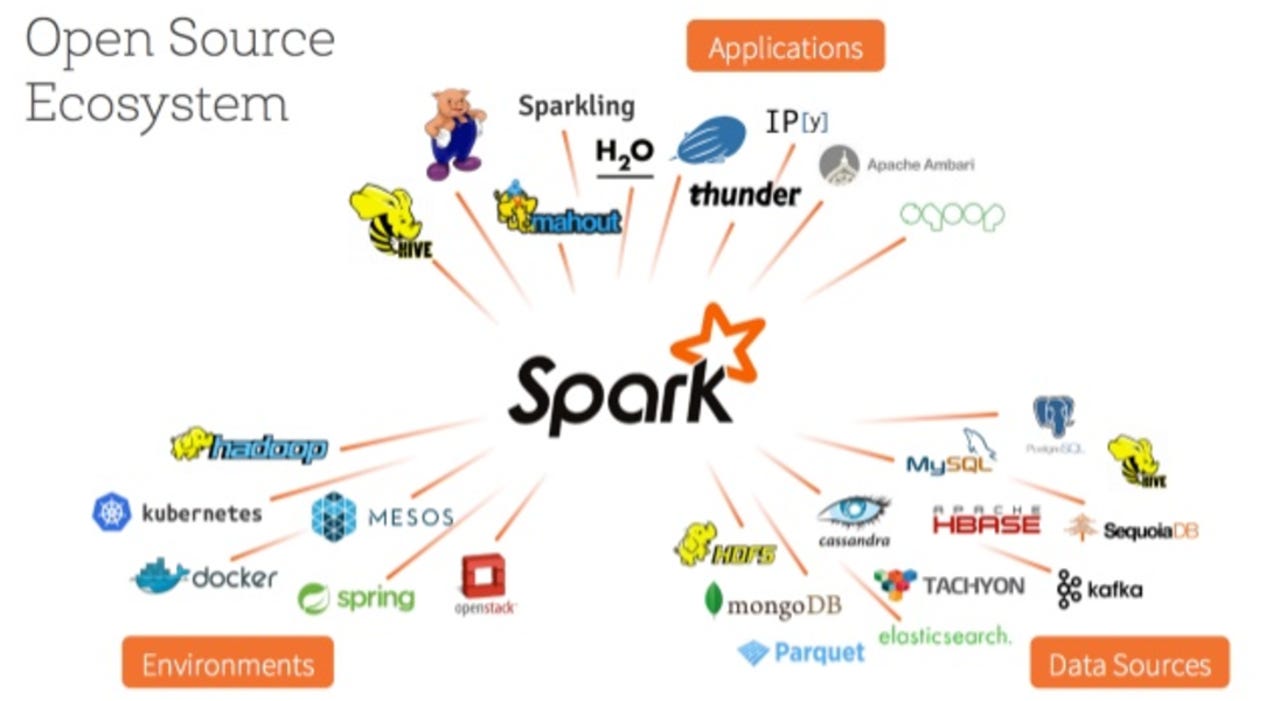

Com certeza! Vamos detalhar o ecossistema Spark de um jeito que faz sentido.

Expandindo Seus Horizontes com o Ecossistema Spark

| Item | Características Principais | Dicas Práticas de quem já usou |

|---|---|---|

| O Que Realmente é o Apache Spark e Por Que Ele Mudou o Jogo? | Plataforma unificada de processamento de big data. Mais rápida que MapReduce. Facilita diversas tarefas de dados. | Pense nele como um canivete suíço para dados. Antes, a gente precisava de várias ferramentas. O Spark juntou tudo. |

| A Arquitetura do Spark: Entendendo os Componentes Essenciais (RDDs, DataFrames, Datasets) | RDDs: Abstração fundamental, tolerante a falhas. DataFrames: Mais estruturado, com otimizações. Datasets: Combina a rigidez do DataFrame com os benefícios de programação orientada a objetos. | Comece explorando DataFrames. Eles são mais fáceis de usar e o Spark já faz um ótimo trabalho otimizando eles para você. RDDs? Use quando precisar de controle total ou para situações bem específicas. |

| Instalando o Spark: Um Roteiro Claro Para Começar Rápido | Requisitos (Java, Scala/Python). Download e configuração do ambiente. Teste de instalação. | Para testar rapidinho, não se prenda à instalação em cluster logo de cara. Rode em modo local. É muito mais simples e você já pega o jeito. |

| Seu Primeiro Processamento com Spark: Exemplo Prático e Detalhado | Carregamento de dados, transformações básicas, ações. Exemplo com um arquivo simples. | Use um CSV pequeno pra começar. O importante é entender o fluxo: carregar, transformar e obter o resultado. Faça passo a passo, sem pressa. |

| Spark SQL: A Maneira Inteligente de Consultar Seus Dados em Larga Escala | Execução de consultas SQL sobre estruturas de dados do Spark. Integração com diversas fontes de dados. | Se você já manja de SQL, vai pegar isso rapidinho. É a forma mais elegante de interagir com dados estruturados no Spark. Economiza muito código. |

| Machine Learning com MLlib: Capacitando Suas Análises Preditivas | API de machine learning. Algoritmos comuns pré-implementados. Escalável. | Não tenha medo de experimentar os algoritmos. Para começar, use os modelos mais simples. Veja o resultado e vá aprimorando. É um ótimo ponto de partida para ML em big data. |

| Processamento de Streaming com Spark: Dados em Tempo Real na Palma da Mão | Processamento de dados que chegam continuamente. Integração com fontes de streaming. Janelas de tempo. | Para streaming, pense em como você vai gerenciar o estado dos dados. O Spark te dá as ferramentas, mas o desenho da sua aplicação é crucial. Comece com exemplos simples de agregação. |

| Otimizando o Desempenho do Spark: Dicas de Um Experiente Para Você | Ajuste de memória, paralelismo, cache, escolha de formatos de arquivo. Monitor |

Confira este vídeo relacionado para mais detalhes:

Superando Desafios Comuns e Maximizando Seus Resultados

Pois é, trabalhar com Spark para processamento de Big Data pode parecer um bicho de sete cabeças, mas a gente vai descomplicar isso. Já passei por cada aperto com dados que você nem imagina. Aqui vão umas dicas de ouro que eu mesmo testei e funcionam:

Minhas Dicas Especiais

- Otimize a Memória: Spark usa muita RAM. Fique de olho em como seus dados estão sendo carregados e se não dá pra reduzir o tamanho. Eu costumo usar a serialização Kryo, que é mais rápida e compacta que a padrão. Dá uma configurada nela no seu `SparkConf`.

- Particione com Inteligência: A forma como você divide seus dados (particionamento) impacta direto na performance. Se os dados não estão bem distribuídos, um nó fica sobrecarregado e o processamento trava. Analise seus dados e escolha o melhor método de particionamento.

- Use o Cache de Forma Estratégica: Repetiu um DataFrame várias vezes? Manda um `.cache()` nele! Isso guarda os dados na memória e evita que o Spark precise recalcular tudo a cada uso. Mas cuidado, não cacheie tudo, só o que você realmente usa várias vezes.

- Monitore as Tarefas: A interface do Spark é sua melhor amiga. Acompanhe o “Spark UI” durante a execução. Lá você vê onde o gargalo está: se é na leitura dos dados, em alguma transformação específica ou na escrita. Isso te ajuda a achar o problema rápido.

- Ajuste o Número de Workers: Nem sempre mais é melhor. Um número exagerado de tarefas pequenas pode gerar mais overhead do que benefício. Comece com um número razoável de partições e veja como o sistema se comporta. Vá ajustando aos poucos.

Dúvidas das Leitoras

Preciso ser um expert em programação para usar o Spark?

Não precisa ser um expert. O Spark é bem mais acessível do que parece, especialmente com as ferramentas certas. Dá para começar a trabalhar com ele sem ter anos de experiência em programação.

O Spark é adequado para pequenas quantidades de dados?

Ele é mais conhecido pelo Big Data, mas o Spark pode sim ser usado com quantidades menores de dados. Se você planeja crescer, usar Spark desde já pode ser uma boa ideia.

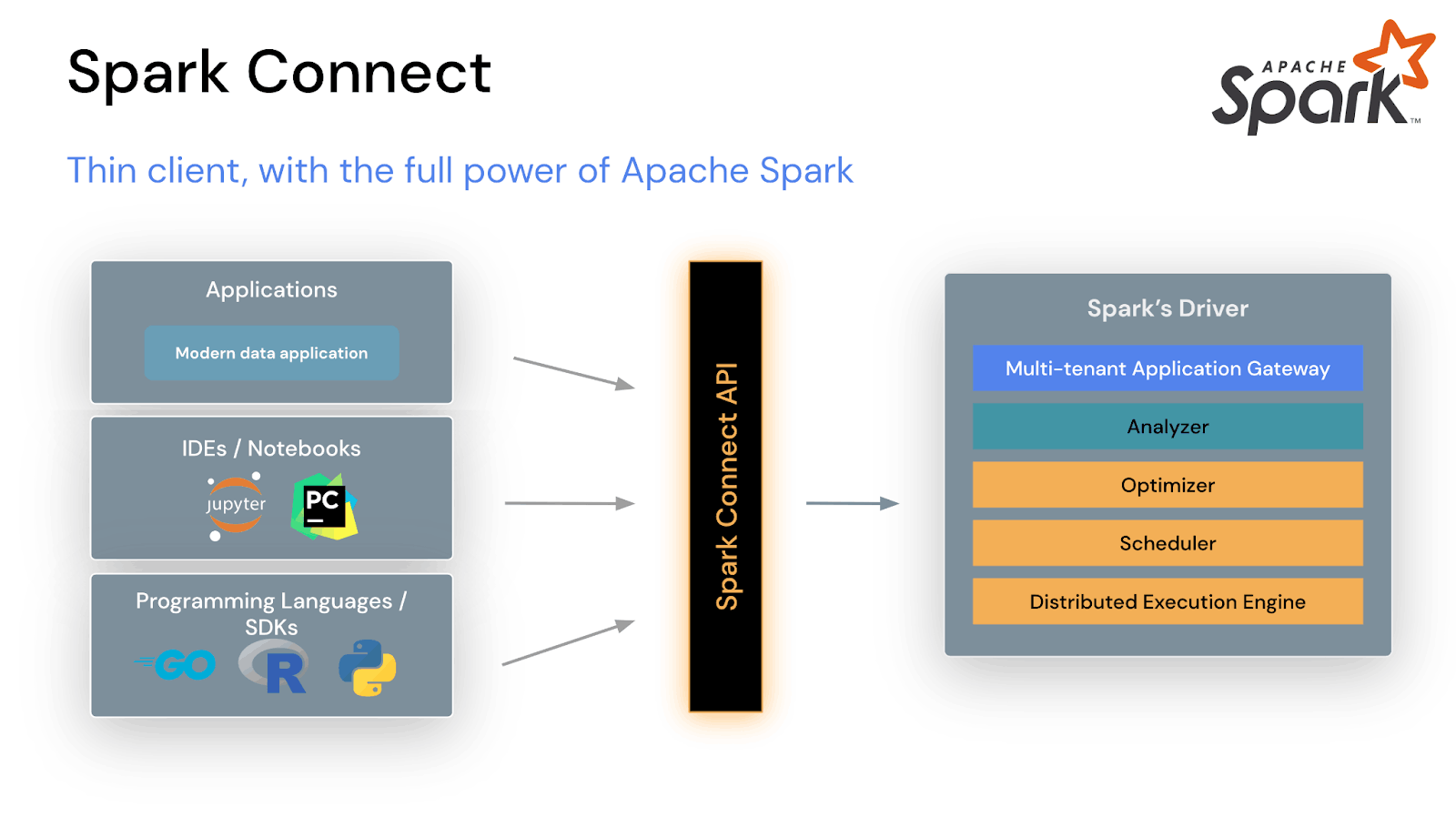

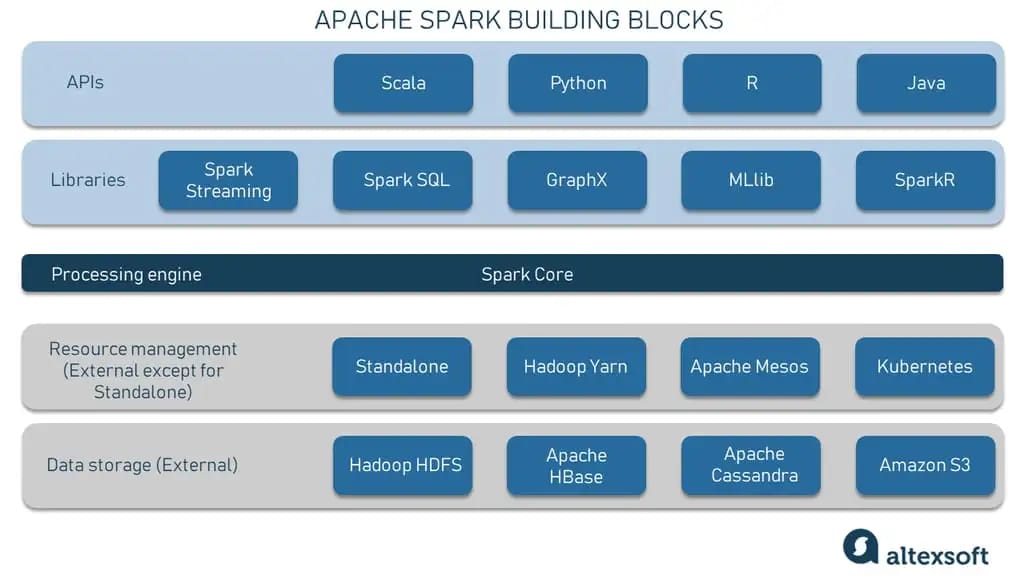

Quais linguagens de programação o Spark suporta?

O Spark tem suporte para várias linguagens populares. Você pode usar Scala, Java, Python e R. Essa flexibilidade te permite trabalhar com a ferramenta que você já domina.

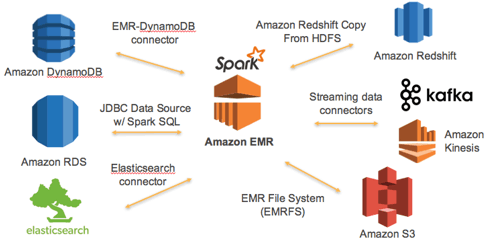

É possível usar o Spark em nuvem?

Com certeza! Usar o Spark na nuvem é super comum e recomendado. Plataformas como AWS, Azure e Google Cloud oferecem serviços gerenciados que facilitam muito a configuração e o uso.

Quais são os pré-requisitos de hardware para rodar o Spark?

Para rodar o Spark, você vai precisar de uma máquina com boa quantidade de RAM e processador. Para testes, um bom computador pessoal já resolve. Para produção, servidores robustos são o caminho.

O Apache Spark é uma ferramenta fantástica para processar grandes volumes de dados. Sua velocidade e flexibilidade o tornam essencial no mundo do Big Data. Se você curtiu aprender sobre Spark, que tal dar uma olhada em como ele se conecta com o processamento em lote (batch processing)? Compartilhe suas experiências ou dúvidas nos comentários!